Januar 19, 2026

Hier findest du die wichtigsten Erklärungen zu unserem Tool: DT Performance Analyser v0.3

Performance-Analyse in Darktable: Den Flaschenhals finden

Darktable ist ein extrem leistungsfähiger RAW-Entwickler, aber diese Leistung fordert ihren Tribut an die Hardware.

Die Performance-Analyse hilft dir zu verstehen, was „unter der Haube“ passiert. Hier erklären wir die wichtigsten Konzepte.

- Wann und wo geht Geschwindigkeit verloren?

- Warum eine schnelle GPU (allein) nicht immer die beste Lösung ist?

Die Informationen bzw. Beispiele auf dieser Seite beziehen sich auf den Export von Fotos, in maximaler Auflösung.

Die Bearbeitung innerhalb von darktable (DT) benötigt (normal) weniger Ressourcen, der Export stellt ein anspruchsvollste Szenario da, genau richtig für die Analyse der Performance.Wenn der Export zügig verläuft, ist eine flüssige Performance während der Bearbeitung sichergestellt.

1. Die Pixelpipe: Ein Fließband für Daten

Du kannst dir die Bearbeitung in Darktable wie ein Fließband vorstellen. Das Bild wird von Modul zu Modul gereicht (z.B. Entrastern -> Belichtung -> Weißabgleich -> Tone Mapping (z.B. AgX).

Das Ziel ist es, das Bild einmal auf die Grafikkarte (GPU) zu laden, dort alle Schritte abzuarbeiten und das fertige Bild zu exportieren.

Wo geht Geschwindigkeit verloren?

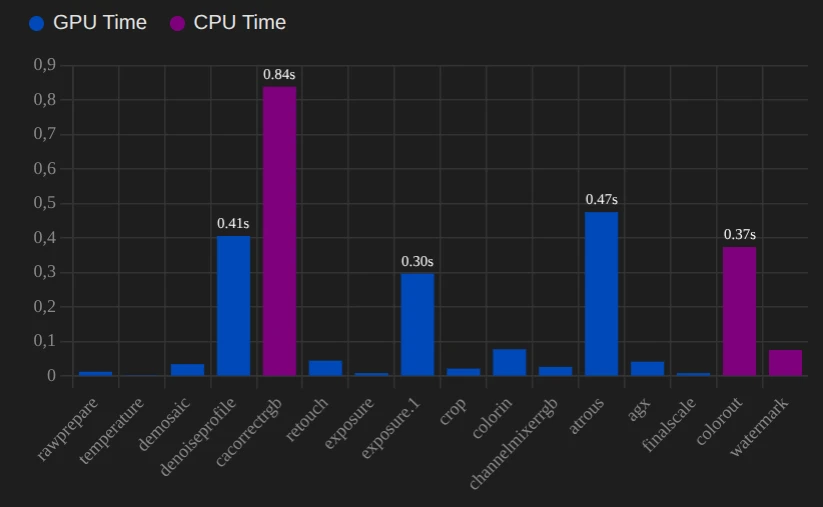

A. Der „Ping-Pong“-Effekt (CPU vs. GPU)

Die eine Bremse, für die Performance, ist nicht immer eine langsame GPU, sondern der unnötige Transport von Daten zwischen GPU und CPU.

- Idealfall: Bild -> GPU -> Modul A -> Modul B -> Modul C -> Ausgabe.

- Problemfall: Bild -> GPU -> Modul A -> CPU-Modul (Daten müssen zurück in den RAM) -> CPU rechnet -> Zurück zur GPU -> Modul C.

Dieser Datentransfer über den PCIe-Bus ist langsam im Vergleich zur Rechengeschwindigkeit. Ein einziges Modul, das nicht auf der GPU läuft, kann die gesamte Pipeline ausbremsen, weil es den Fluss unterbricht.

Die Abbildung rechts, zeigt dir die Unterschiede, der Verarbeitungszeit, zwischen GPU und CPU.

Wann kommt es zu diesem Problem?

- Das Modul hat keine OpenCl Unterstützung, die Bearbeitung erfolgt damit auf der CPU.

- Zu wenig Speicher der GPU (VRAM).

Nicht jedes Modul kann, kann Tiling (nächster Abschnitt) verwenden, reicht der Speicher der GPU nicht aus, gibt es nur den Umweg über die CPU.

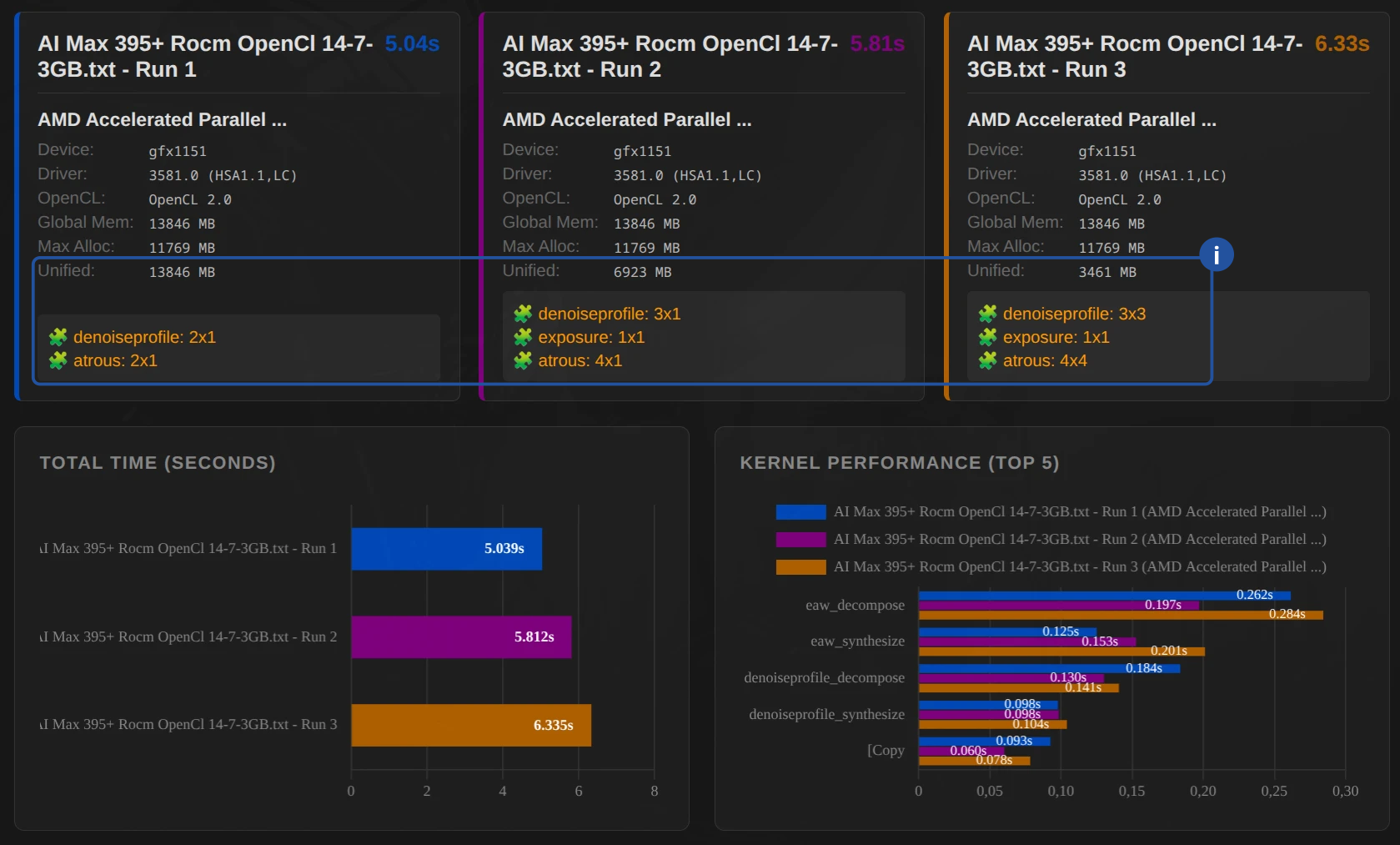

B. Tiling (Kachelung)

Grafikkarten haben sehr schnellen, aber begrenzten Speicher (VRAM). Ein 24-Megapixel-Bild belegt im VRAM, während der Bearbeitung, oft mehrere Gigabyte.

- Was passiert? Wenn das Bild nicht am Stück in den VRAM der GPU passt, zerlegt Darktable es in Kacheln (Tiles).

- Der Nachteil: Jede Kachel muss einzeln berechnet werden. Damit man keine Kanten sieht, müssen die Kacheln überlappen („Ghosting“). Diese Überlappungsbereiche werden also doppelt berechnet.

- Die Folge: Tiling ermöglicht zwar den Export riesiger Bilder auf kleinen Grafikkarten, kostet aber (meist) Performance.

2. Die Treiber-Schnittstellen: Wer spricht mit der Hardware?

Darktable nutzt OpenCL, um mit der Grafikkarte zu sprechen. Doch wie OpenCL umgesetzt wird, macht einen Unterschied.

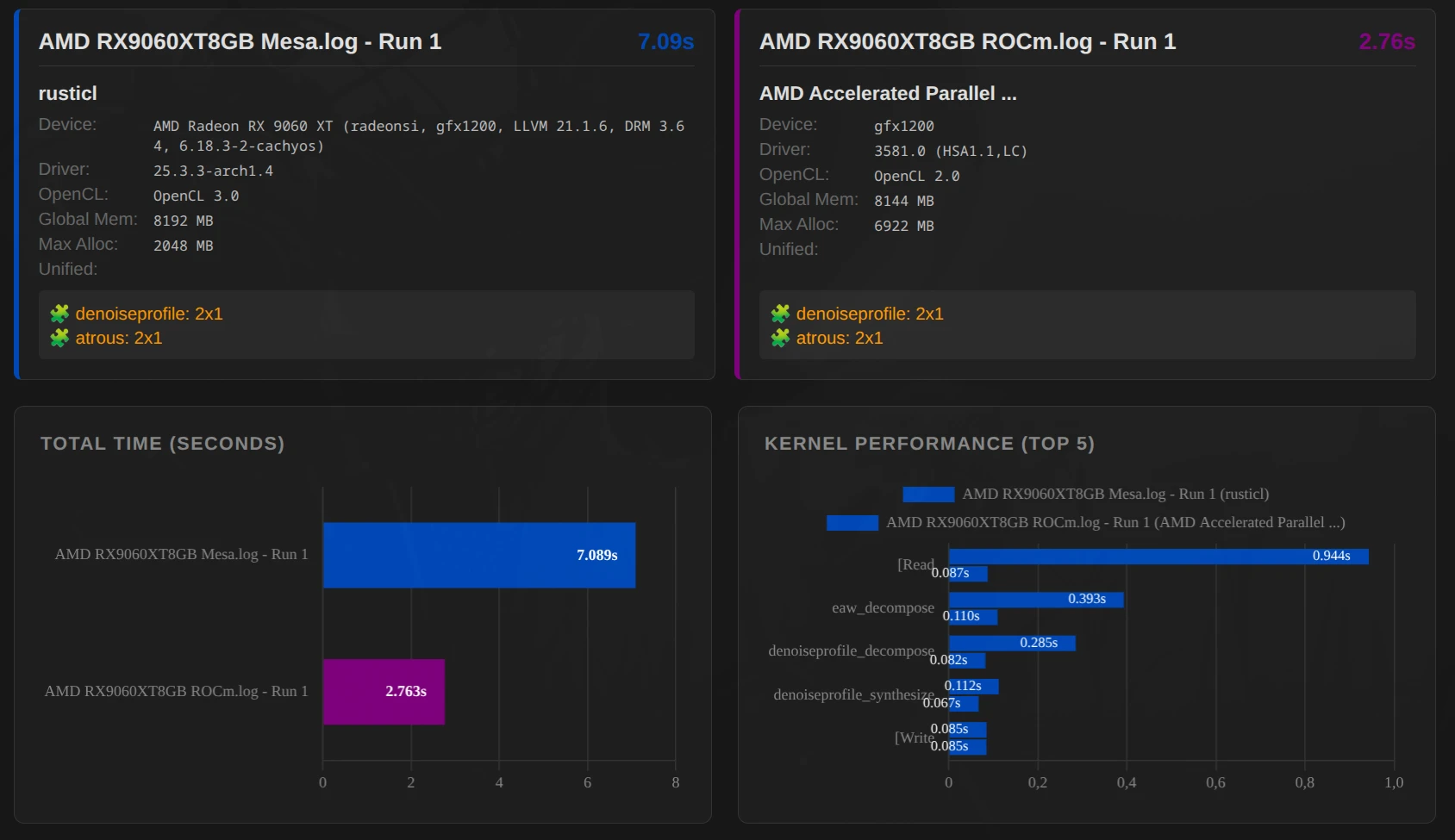

Beispie: AMD RX 9060 XT mit 8GB (gfx1200) – OpenCl-Mesa (RustiCl) vs. ROCm

Wichtig: Das Beispiel liefert keine Aussage darüber ob ROCm generell besser ist als OpenCl-Mesa! Je nach System kann das unterschiedlich sein.

ROCm (Radeon Open Compute)

Dies ist AMDs moderner Ansatz für High-Performance-Computing unter Linux.

- Vorteil: Oft sehr schnell und stabil bei neueren Karten (RX 6000/7000/9000 Serie). Nutzt die Hardware sehr effizient.

- Nachteil: Offiziell nur für bestimmte Distributionen und Karten unterstützt, manchmal frickelig bei der Installation.

Rusticl (OpenCl-Mesa)

Ein neuerer, in der Sprache Rust geschriebener OpenCL-Treiber, der Teil des Mesa-Projekts ist.

- Vorteil: Funktioniert oft „Out of the Box“ auf vielen Linux-Systemen und unterstützt auch ältere Hardware oder integrierte Grafikeinheiten (iGPUs), die von den proprietären Treibern nicht mehr gepflegt werden.

- Performance: Inzwischen oft auf Augenhöhe mit den proprietären Treibern, manchmal sogar schneller bei spezifischen Aufgaben.

Proprietäre Treiber (AMD Pro / Nvidia)

- Nvidia: Hier gibt es kaum Alternativen. Der proprietäre Treiber ist extrem ausgereift und performant.

- AMD Pro: Meist solide, aber unter Linux wird er zunehmend von ROCm oder Rusticl verdrängt.

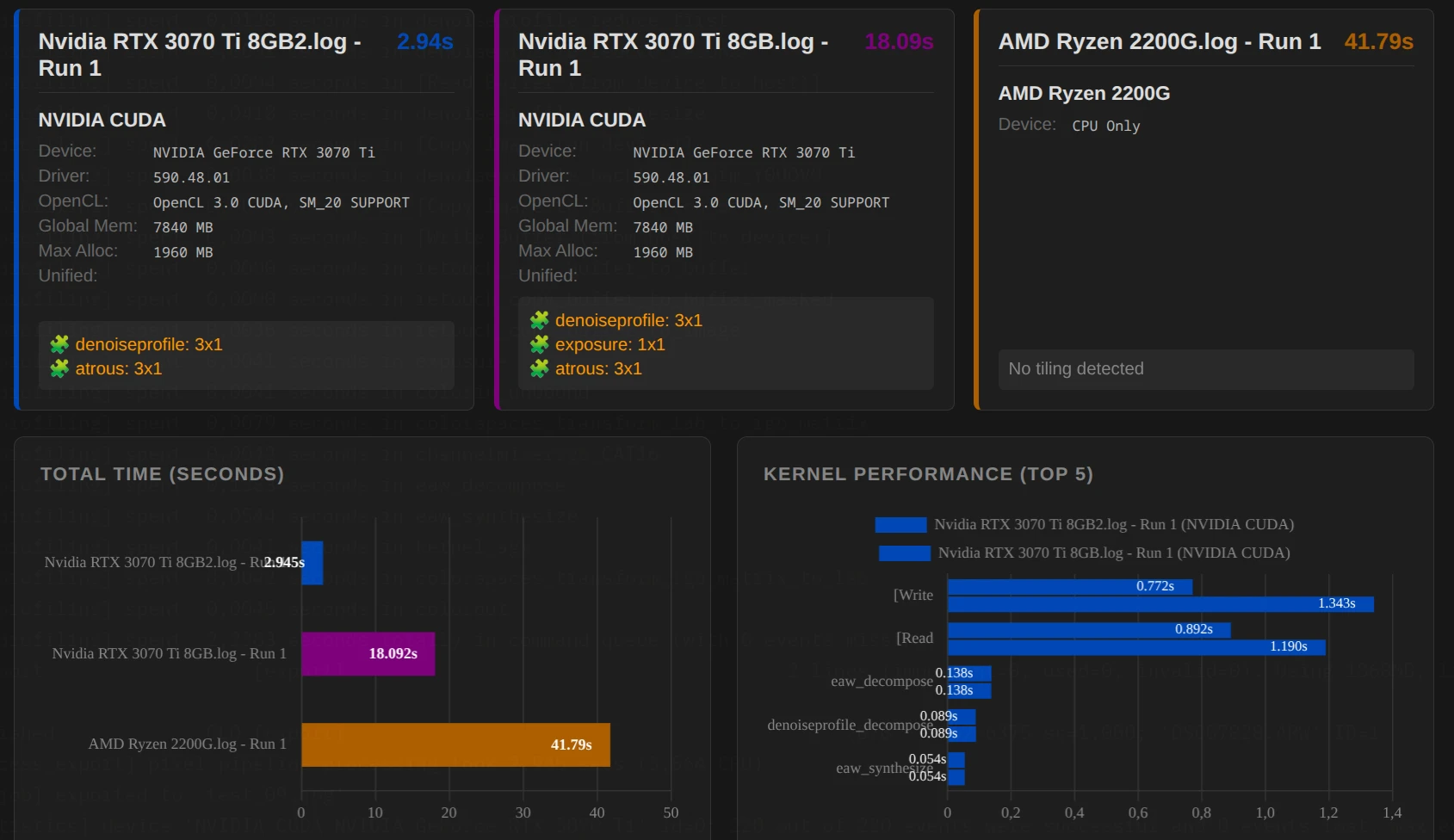

3. Warum CPU-Only keine Option ist

Moderne Bildbearbeitungsalgorithmen (wie Diffuse & Schärfen oder Entrauschen (Profil)) führen Millionen von Berechnungen pro Pixel durch.

- Eine CPU hat wenige, sehr komplexe Kerne (z.B. 16 Kerne).

- Eine GPU hat tausende, simple Kerne (z.B. 4000 Shader-Einheiten).

Für Bildbearbeitung, wo jedes Pixel parallel bearbeitet werden kann, ist die GPU der CPU um den Faktor 10 bis 100 überlegen. Die Performance-Analyse zeigt dies gnadenlos: Ein Export, der auf der GPU 2 Sekunden dauert, kann auf der CPU 40 Sekunden benötigen.

4. Fazit

Wie hilft mir die Analyse weiter?

Die Analyse dient als Diagnose-Werkzeug: Wenn DT stockt oder der Export zu lange dauert, siehst du hier sofort, welche Komponente (CPU, GPU oder RAM) der Flaschenhals ist. Damit kannst du gezielt dort ansetzen, wo die Hardware limitiert. Das gleiche gilt für den Grafiktreiber.

Handlungsmöglichkeiten

Bei der Arbeit in darktable:

- Module temporär deaktivieren: Schalte rechenintensive Module, die für den Look im Moment nicht entscheidend sind (z. B. Diffundieren oder Schärfen, Entrauschen), erst ganz am Ende der Bearbeitung ein. Das hält die Vorschau flüssig.

Wichtig: Die Reihenfolge der Module in der Pixelpipe von darktable ist fest vorgegeben. Auch wenn du ein Modul „später“ einschaltet, wird es an der technisch korrekten Stelle berechnet – es lohnt sich also, die „schweren Brocken“ bis zum Schluss deaktiviert zu lassen. - OpenCL-Treiber optimieren (Linux/AMD): Teste, ob deine AMD-Karte mit dem ROCm-Treiber oder dem neueren Rusticl-Stack besser performt. Ein einfacher A/B-Test (Exportzeit stoppen) bringt hier schnell Klarheit.

- iGPU-Speichermanagement: Falls du keine dedizierte Grafikkarte hast, weise der iGPU im BIOS mehr System-RAM zu. Während 4 GB für einfache Bearbeitungen reichen, sind 8 GB oder 16 GB bei hochauflösenden Sensoren und komplexen Modulen deutlich stabiler.

Beim Export:

- Gezielte Skalierung: Wenn das Foto nur für Social Media oder Web gedacht ist, skaliere die Auflösung bereits beim Export herunter. Das spart Rechenzeit und Speicherplatz.

- OpenCL-Priorisierung: Stelle in den darktable-Einstellungen sicher, dass die GPU beim Export bevorzugt wird (Profil „Sehr schnelle GPU“ oder „Mehrere GPUs“), um die CPU zu entlasten.